AndyZ 2019-6-23 from Matters

【本文为系列文章的第二篇,大概算是前一篇的海外案例扩充版。下一篇讲泛中文互联网世界】

大概是因为美国大选和英国脱欧的影响,互联网上的政治宣传或者舆论操控近年来越来越受到了媒体和大众的重视。但其实,学术界在很多年前就已经开始重视这个问题了。互联网,包括但不限于社交媒体,带来的庞大信息量会如何对受众的心理和行为产生影响,尤其是在政治领域,这一直都是政治学、传播学、信息科学领域内的重要话题。

而政治界其实和学术界一样好奇并愿意了解互联网对民众观念的影响力,所以internet所到之处,政客们都是迫不及待地用起来。而当他们理解互联网的强大传播力后,利用新技术进化传统的政治宣传手段自然而然地成了不少人的选择。

除了比较常见的"官方账号发布政治内容"这种普通的"互联网+政治"模式外,我想人们对"互联网宣传对现实政治产生影响"比较普遍的理解是,虚假信息被水军们传播从而欺骗误导了选民。这确实是一个特别明显的例子,不过整个互联网宣传战并不止于此。那些水军账号们的目的不仅仅是要操控选举,也可能是要干扰正常的公共交流、加剧社会割裂、影响社会运动,等等等等。

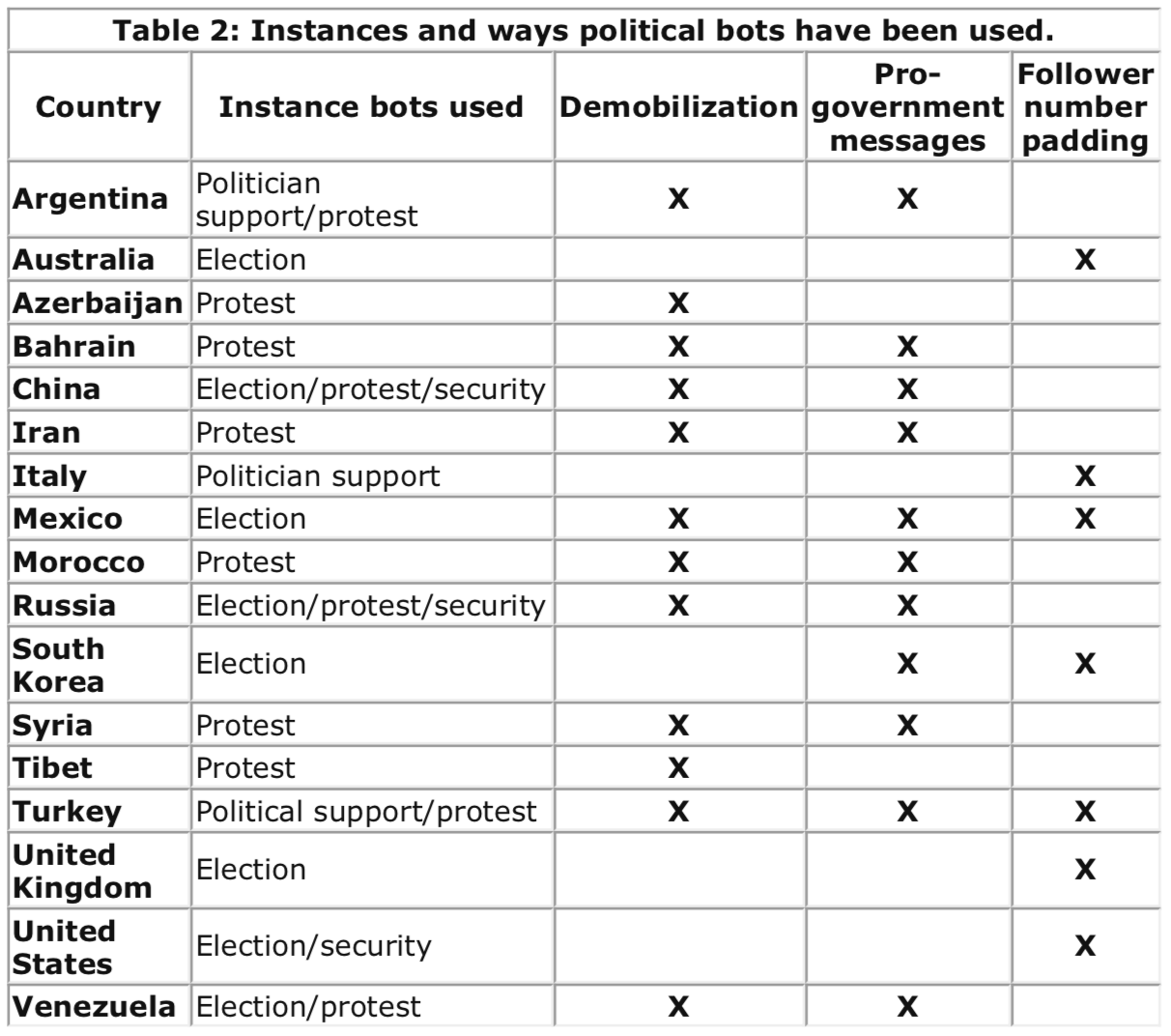

Samuel Woolley在2016年时就对此做过一个很好的综述,我也就不详细复述了。核心大意就是,政治参与者已经越来越多地采用自动化手段在互联网上传播特定内容,扭曲公共舆论和意见。下面这张出自其综述的表格就展现了,在2016年时全球已知的各种政治类机器人的使用情况。

"China" 只包括中国大陆当局在海内外使用的机器人,"Tibet"是特指在西藏冲突中使用的中文机器人

"China" 只包括中国大陆当局在海内外使用的机器人,"Tibet"是特指在西藏冲突中使用的中文机器人

可以看出,互联网宣传战是一个全球性的问题,而同时这也是一个极具地方性的问题。虽然在数字世界里,宣传战并是没有国界限制或分类的,但不过不少的宣传行动(propaganda campaign)确实能够看出明显的受众对象。比如被讨论得最多的,俄罗斯水军干预美国大选。而且,也不要以为恶意的政治水军不会出现于民主国家。在韩国,政治水军不止一次介入过总统大选,有的帮朴槿惠,也有的帮文在寅。

互联网政治水军并不是一个是一个非常有策略性且在不断进化的群体。它们擅长使用计算机程序来操控账号、喜欢使用hashtag,会制造出远远超过自身比例的内容(在英国脱欧的案例中,1%的账号制造了三分之一的内容)。它们会传播特定媒体的新闻内容,会在低可信度的内容被创作的早期积极转发,通过各种手段吸引普通用户的注意。普通人自然无力抵抗这种被精心设计的圈套,很容易就会加入传播链,成为这个宣传病毒的感染者和传播源。

这可能就是大家或多或少都知道的,水军如何靠着散布假新闻来扭曲舆论。不过有一个需要澄清的是,虚假错误信息,既不是水军内容的必需条件,也不是充分条件。很多半真半假、或者刻意误导的信息也有着极大的吸引力和伤害力;普通人也可能在信息的制造和传播中出错,产生有问题的内容。

(伪装成)脚注:Disinformation(假消息,有时候人们也会用Fake News指代)通常是指的被刻意扭曲的信息;misinformation(错误信息)则是在制造、传播等过程中无意失实的信息(我认为其制造传播者并不应该收到太多苛责)。当然,很多时候无法分辨出来,两者也共同恶化了互联网信息环境。

当然,它们的策略也可能更为复杂和精细,甚至看起来和政治毫无关系。有研究发现,在反疫苗的网络中舆论中也有大量的宣传战痕迹——参与者包括机器人账号、会传播恶意软件和商业信息的内容污染者、明确与俄罗斯政府有关的真人水军(troll)。比起普通用户,这些账号都明显更加活跃;然而,策略却不一致。机器人和内容污染者致力于扩散反疫苗的内容,俄罗斯水军却是在两边用力,同时煽动意见不同的两方,加剧对立冲突。这种手法总结一下就是,先由机器人低成本地创造大量宣传原材料,然后再由真人水军介入同时向两方扩散,尝试制造反感,破坏对话。这种同时加入双方论战、制造冲突的手法并不鲜见,最著名的案例就是BlackLiveMatters运动,俄罗斯水军就装成了活动分子和两方论战者,左右互搏,积极制造冲突对立。(顺带一提,这种手法在简体中文舆论中很能见到,而且在关于中国的讨论和关于欧美政治的讨论中都有。)

反疫苗案例的研究者认为这种关于健康议题的舆论(health communication)已经被"武器化"(weaponized)了:有恶意的境外势力(foreign power...他们真的是用的这个词语……)故意散播虚假错误信息来误导民众。而且,其中还有大比例的推特是来自于身分不明、但有恶意行为的激进用户在参与,这样一来,反疫苗的议题被人为制造出来了火热辩论的景象。这种宣传手法被称为astroturfing,这个词来自于astroturf(草皮),意思是利用伪装成普通草根层面的账号进行信息宣传,也可以就简单理解成"灌水"。

这个案例其实有个很有趣的地方,在于表明哪怕是明显的政治性水军(因为明确和俄罗斯政府有关),也可以介入表面看起来非政治性的议题,进入深化社会矛盾情绪。另一个值得注意的是,有不少参与反疫苗争论的账号同时也在传播恶意软件或者商业信息。如果排除掉运营者在顺便挣点外快的可能,这倒是让我有点怀疑它们的身份其实并非政治性水军,而是商业性账号。背后的运营者在"洗粉"——通过某种特定内容的信息,聚集一大批特定类型和偏好的受众,就可以在未来进行定制的营销或者宣传。要向受众大量灌输某一立场的观点/推销特定种类的产品前,这种有目的性的宣传账号/营销账号都会先不断地发布受某群体喜欢的信息、发布某方激进观念,从而吸引更多的潜在受众并让受众群体变得越来越相似且容易信服。

不过,水军也不一定总是有效,这可能非常取决于它们在哪里活动,采取了什么方式。比如在委内瑞拉,研究者就发现(至少是在那个特定时间段内的Twitter上)政治性机器人账号虽然存在,但是影响力并不大,而且比起散播假消息和攻击政客,主要也是用于传播活动信息。甚至,政府里的官僚主义和低水平的动机也会造成宣传效果的大打折扣,这种例子就是中国水军,今后会撰文详谈。

多数研究都会重视机器人(bot)——由电脑程序控制的社交媒体账号——在灌水宣传中的使用。随着社交机器人的大规模出现,这几乎成了每一个互联网舆论研究中都难以忽略的问题。不过要研究机器人究竟发挥了怎么样的作用,最大的问题就是怎么辨别。最常用的做法是直接使用印第安纳大学的团队开发出来的检测工具BotorNot (现在叫Botometer)。还有些研究者会因为这个工具的某些局限性,选择采用其他指标——比如发布平台或者时间——来判断是否是机器人。

当然,这在某种程度上也是一个猫捉老鼠的游戏。因为研究者可以比较容易地通过各类元数据找出机器人账号,那么社交媒体公司(比如Twitter)也能发现它们,那样的话这些机器人账号就很容易被屏蔽了。所以现在研究者就会发现,机器人们越来越复杂了,用传统手段未必能够轻易识别。

不过,这背后可能还有一个原因是,现在网络上的宣传账号,很多并不是100%的机器人,而是被真人和计算机程序混用的。甚至在针对英国脱欧的政治宣传中,不同立场的水军账号有着程度不一的自动化特点。反疫苗的舆论中,也有很多看起来相对复杂的机器人账号以及无法被识别的账号。

我个人以为,互联网上以虚假错误消息为主要内容的政治宣传带来的最大危害并非是误导了选民进而改变了选举,而是污染了有价值的信息、干扰了公共议事、扭曲了公共意见、让人们丧失对交流的信心和兴趣、进而造成了整个社会的各群体阶层的割裂对立。选举没有得到最好的结果,还可以通过其他手段补救、止损;然而,如果当权者不再能够通过社会舆论判断出民众的偏好变化,如果民众并不再愿意通过对话去介入公共生活,如果多数人都无法在数字世界里找到可靠的、有价值的信息,那我们将面临一个无法让人乐观的世界。这一点,对非民主制国家成立,对民主制国家也成立。

不过,最后想说的是,我们不应该将川普的上台、英国的脱欧归咎于社交媒体、网络水军或者俄罗斯。我不否认他们会带来影响,但这背后其实还有更深刻的社会问题——为什么人们愿意相信并传播那些信息。水军们抓住了人性的弱点是肯定的,但这恐怕并不是可以那么简单回答的。虚假/错误信息的问题一直是存在的,这并不是数字时代独有的(当然,要说社交媒体加剧了这个问题,也站得住脚)。我们如今面临的问题是并非是"把社交媒体管起来""惩罚造谣者""打击俄罗斯水军"就可以解决的,甚至这些方法很可能会适得其反。不过,这并不在我的研究范畴内,就不啰嗦了。

没有评论:

发表评论